教導 AI 看見與說話:深入了解 OW‑VISCap 方法

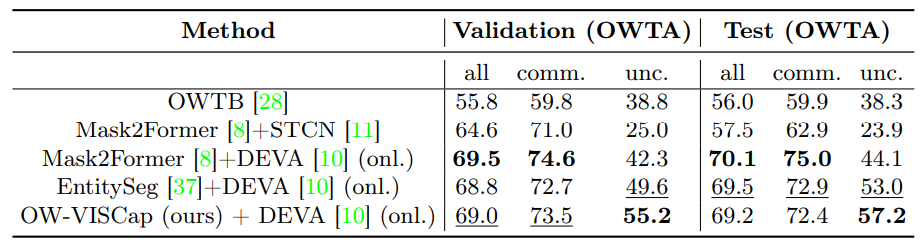

連結表格

摘要和 1. 引言

-

相關工作

2.1 開放世界視頻實例分割

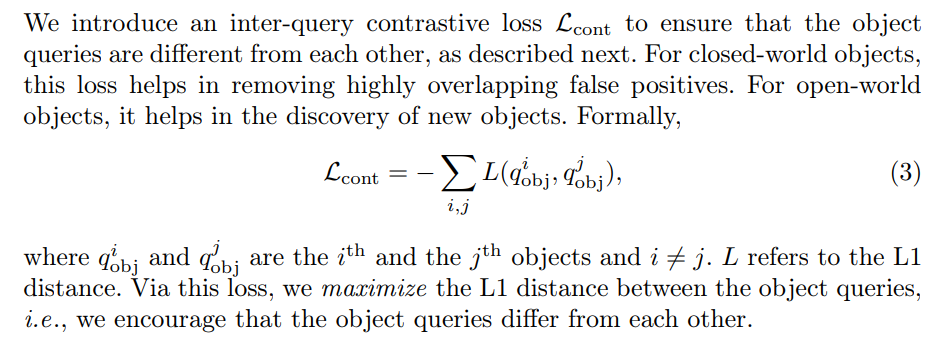

2.2 密集視頻物體描述和 2.3 物體查詢的對比損失

2.4 通用視頻理解和 2.5 封閉世界視頻實例分割

-

方法

3.1 概述

3.2 開放世界物體查詢

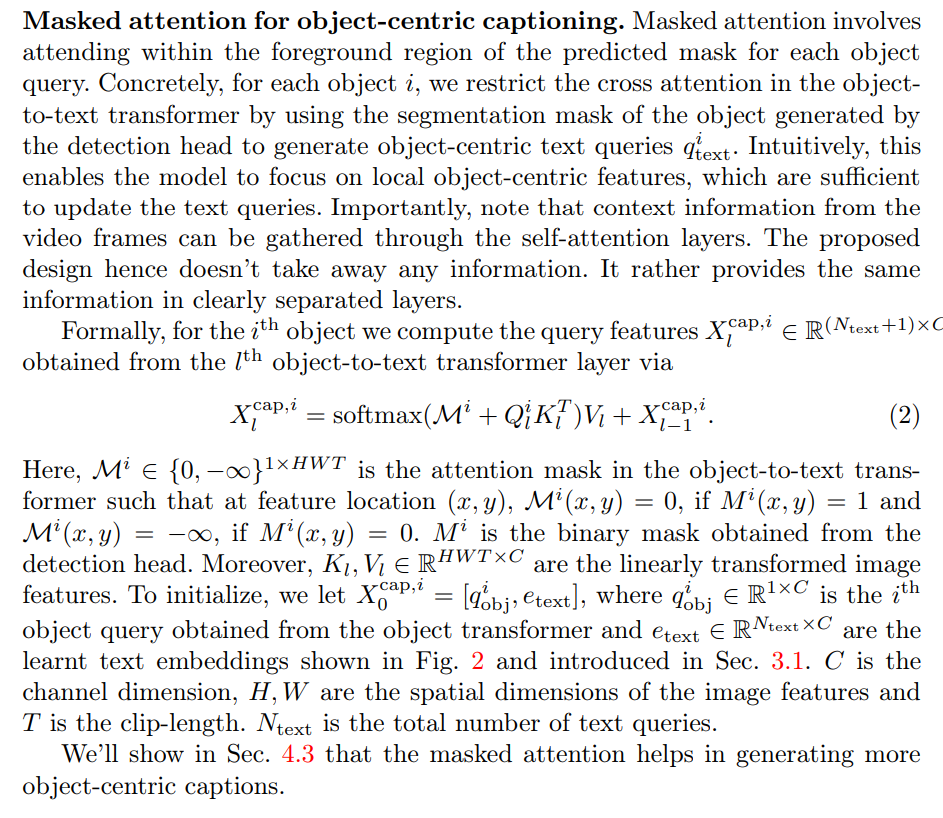

3.3 描述頭

3.4 查詢間對比損失和 3.5 訓練

-

實驗和 4.1 數據集和評估指標

4.2 主要結果

4.3 消融研究和 4.4 定性結果

-

結論、致謝和參考文獻

\ 補充材料

A. 額外分析

B. 實現細節

C. 局限性

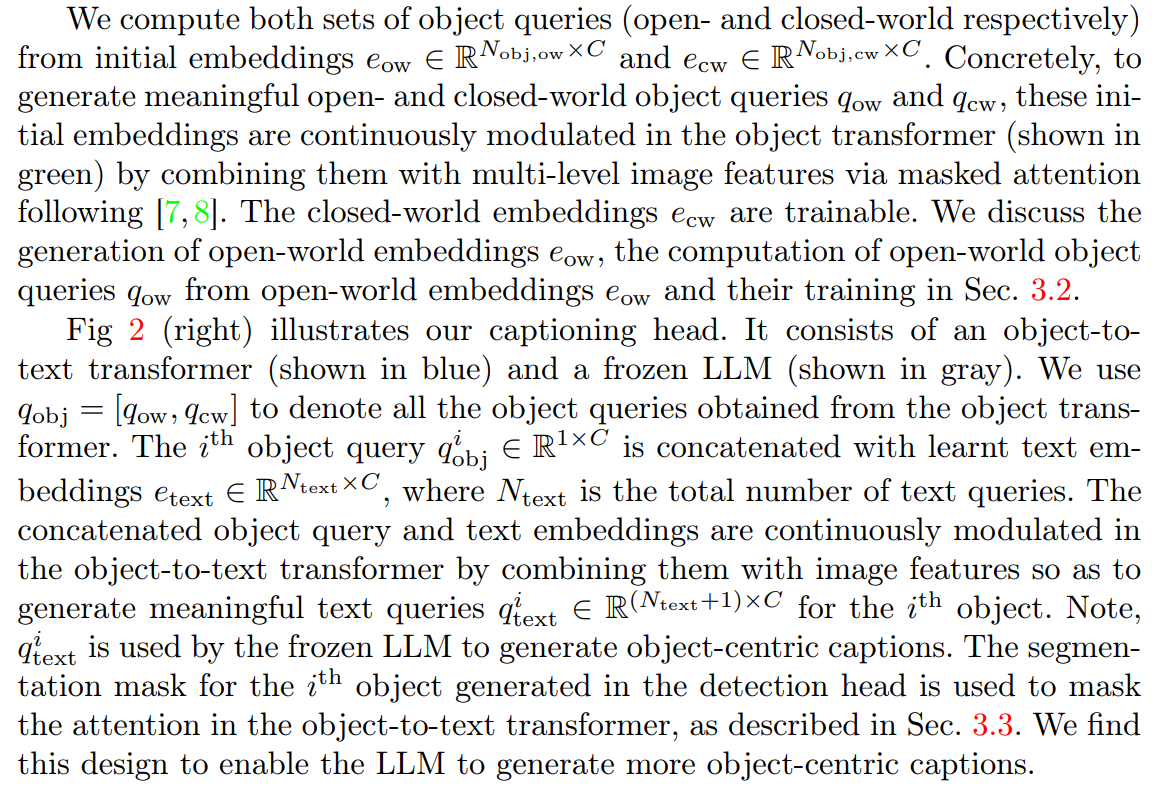

3 方法

給定一個視頻,我們的目標是聯合檢測、分割和描述視頻中存在的物體實例。重要的是,請注意物體實例類別可能不是訓練集的一部分(例如,圖 3(頂行)中顯示的降落傘),將我們的目標置於開放世界設置中。為了實現這一目標,給定的視頻首先被分解成短片段,每個片段由 T 幀組成。每個片段使用我們的方法 OW-VISCap 進行處理。我們在第 4 節討論每個片段結果的合併。

\ 我們在 3.1 節提供 OW-VISCap 處理每個片段的概述。然後我們討論我們的貢獻:(a) 在 3.2 節中引入開放世界物體查詢,(b) 在 3.3 節中使用遮罩注意力進行以物體為中心的描述,以及 (c) 在 3.4 節中使用查詢間對比損失以確保物體查詢彼此不同。在 3.5 節中,我們討論最終的訓練目標。

3.1 概述

\ 開放世界和封閉世界物體查詢都由我們專門設計的描述頭處理,該頭產生以物體為中心的描述,分類頭產生類別標籤,以及檢測頭產生分割掩碼或邊界框。

\

\ 我們引入查詢間對比損失以確保鼓勵物體查詢彼此不同。我們在 3.4 節提供詳細信息。對於封閉世界物體,這種損失有助於消除高度重疊的假陽性。對於開放世界物體,它有助於發現新物體。

\ 最後,我們在 3.5 節提供完整的訓練目標。

\

3.2 開放世界物體查詢

\

\

\ 我們首先使用匈牙利算法[34]通過最小化匹配成本將真實物體與開放世界預測匹配。然後使用最佳匹配計算最終的開放世界損失。

\

\

3.3 描述頭

\

\

3.4 查詢間對比損失

\

\

3.5 訓練

我們的總訓練損失是

\

\ ![表 2:VidSTG [57] 數據集上的密集視頻物體描述結果。Off. 表示離線方法,onl. 指在線方法。](https://cdn.hackernoon.com/images/null-0v3336a.png)

\

:::info 作者:

(1) Anwesa Choudhuri,伊利諾伊大學厄巴納-香檳分校 (anwesac2@illinois.edu);

(2) Girish Chowdhary,伊利諾伊大學厄巴納-香檳分校 (girishc@illinois.edu);

(3) Alexander G. Schwing,伊利諾伊大學厄巴納-香檳分校 (aschwing@illinois.edu)。

:::

:::info 本論文可在 arxiv 上獲取,根據 CC by 4.0 Deed (Attribution 4.0 International) 許可證。

:::

\

您可能也會喜歡

Tether 與越南峴港市簽署了諒解備忘錄,以推進區塊鏈驅動的數位治理和基礎設施發展。

狗狗幣價格在 $0.16 找到支撐,顯示潛在短期反彈