OpenAI Avverte che i Modelli di IA di Nuova Generazione Presentano Elevati Rischi per la Cybersicurezza

TLDR

- OpenAI ha emesso un avvertimento che i suoi modelli AI di nuova generazione presentano rischi di cybersecurity "elevati" e potrebbero creare exploit zero-day

- GPT-5.1-Codex-Max ha raggiunto il 76% nei test di cybersecurity a novembre 2025, un forte aumento rispetto al 27% di GPT-5 ad agosto 2024

- L'azienda sta lanciando Aardvark, un Agente IA focalizzato sulla sicurezza che identifica vulnerabilità nel codice e suggerisce correzioni

- OpenAI prevede di creare un Frontier Risk Council con esperti di cybersecurity e offrire accesso a livelli alle funzionalità di sicurezza avanzate

- Anche Google e Anthropic hanno rafforzato i loro sistemi di IA contro le minacce alla cybersecurity negli ultimi mesi

OpenAI ha rilasciato un avvertimento il 10 dicembre affermando che i suoi prossimi modelli di IA potrebbero creare seri rischi per la cybersecurity. L'azienda dietro ChatGPT ha dichiarato che questi modelli avanzati potrebbero costruire exploit remoti zero-day funzionanti mirati a sistemi ben difesi.

L'azienda di IA ha anche notato che questi modelli potrebbero aiutare con operazioni di intrusione aziendali o industriali complesse che portano a conseguenze nel mondo reale. OpenAI ha condiviso queste informazioni in un post sul blog affrontando le crescenti capacità della sua tecnologia.

L'avvertimento riflette le preoccupazioni in tutta l'industria dell'IA riguardo al potenziale uso improprio di modelli sempre più potenti. Diverse importanti aziende tecnologiche hanno preso provvedimenti per proteggere i loro sistemi di IA contro minacce simili.

Google ha annunciato aggiornamenti alla sicurezza del browser Chrome questa settimana per bloccare attacchi di iniezione indiretta di prompt sugli Agenti IA. I cambiamenti sono arrivati prima di un più ampio lancio delle funzionalità agentiche di Gemini in Chrome.

Anthropic ha rivelato a novembre 2025 che attori minacciosi, potenzialmente collegati a un gruppo sponsorizzato dallo stato cinese, avevano utilizzato il suo strumento Claude Code per un'operazione di spionaggio Basato su IA. L'azienda ha fermato la campagna prima che causasse danni.

Le Competenze di Cybersecurity dell'IA Avanzano Rapidamente

OpenAI ha condiviso dati che mostrano rapidi progressi nelle capacità di cybersecurity dell'IA. Il modello GPT-5.1-Codex-Max dell'azienda ha raggiunto il 76% nelle sfide capture-the-flag a novembre 2025.

Questo rappresenta un grande salto rispetto al punteggio del 27% che GPT-5 ha ottenuto ad agosto 2024. Le sfide capture-the-flag misurano quanto bene i sistemi possono individuare e sfruttare le debolezze di sicurezza.

Il miglioramento in soli pochi mesi mostra quanto velocemente i modelli di IA stiano acquisendo capacità avanzate di cybersecurity. Queste competenze possono essere utilizzate sia per scopi difensivi che offensivi.

Nuovi Strumenti di Sicurezza e Misure di Protezione

OpenAI ha dichiarato che sta costruendo modelli più forti per il lavoro di cybersecurity difensiva. L'azienda sta sviluppando strumenti per aiutare i team di sicurezza a controllare il codice e correggere le vulnerabilità più facilmente.

L'azienda supportata da Microsoft sta utilizzando più livelli di sicurezza tra cui controlli di accesso, rafforzamento dell'infrastruttura, controlli di uscita e sistemi di monitoraggio. OpenAI sta addestrando i suoi modelli di IA a rifiutare richieste dannose pur rimanendo utili per l'educazione e il lavoro di difesa.

L'azienda sta espandendo il monitoraggio su tutti i prodotti utilizzando modelli di frontiera per catturare attività cyber potenzialmente dannose. OpenAI sta collaborando con gruppi esperti di red teaming per testare e migliorare i suoi sistemi di sicurezza.

Strumento Aardvark e Consiglio Consultivo

OpenAI ha introdotto Aardvark, un Agente IA che funziona come ricercatore di sicurezza. Lo strumento è in Test Beta pubblico e può scansionare il codice per vulnerabilità e raccomandare patch.

I manutentori possono implementare rapidamente le correzioni proposte da Aardvark. OpenAI prevede di offrire Aardvark gratuitamente a repository di codice open source non commerciali selezionati.

L'azienda lancerà un programma che darà agli utenti e clienti qualificati di cyberdifesa accesso a livelli a capacità avanzate. OpenAI sta formando il Frontier Risk Council, portando difensori cyber esterni ed esperti di sicurezza a lavorare con i suoi team interni.

Il consiglio inizierà concentrandosi sulla cybersecurity prima di espandersi ad altre aree di capacità di frontiera. OpenAI fornirà presto dettagli sul programma di accesso fidato per utenti e sviluppatori che lavorano sulla cyberdifesa.

Il post OpenAI avverte che i modelli di IA di nuova generazione pongono elevati rischi per la cybersecurity è apparso per primo su Blockonomi.

Potrebbe anche piacerti

Le Speculazioni Aumentano Intorno a XRP Dopo l'Acquisto di MoonPay e il Via Libera di Cboe per un Nuovo Spot ETF

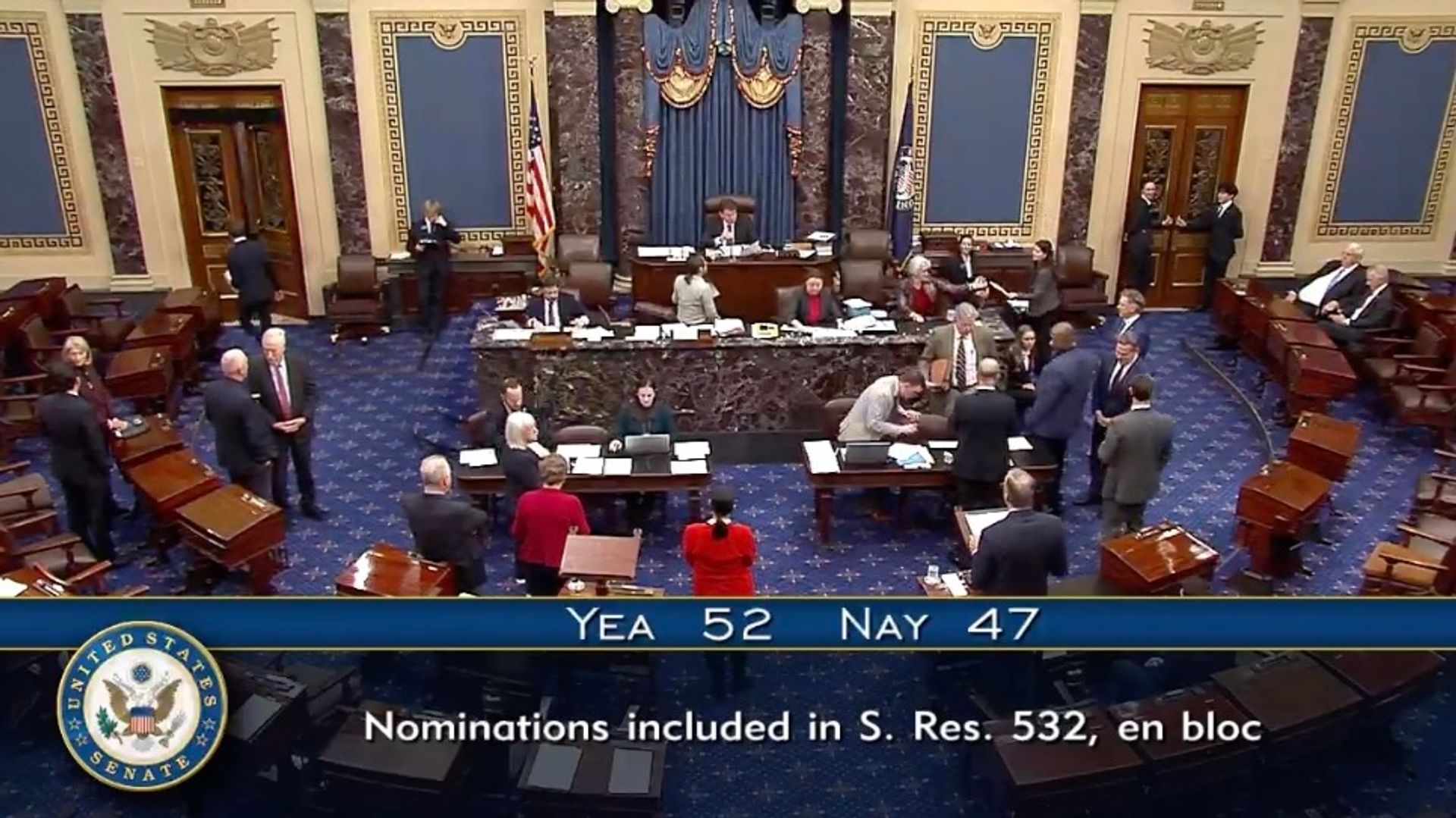

Il Senato degli Stati Uniti Procede Verso l'Ultimo Voto per Confermare i Regolatori Crypto presso CFTC, FDIC

Copia linkX (Twitter)LinkedInFacebookEmail